Comme nous l’avons vu dans « Preuve ou indice ? », en médecine les études reposent essentiellement sur des tests statistiques. L’objectif étant de savoir si les résultats sont statistiquement significatifs, les articles scientifiques, dans leur chapitre de résultats, se caractérisent par une succession de petits « p » qui permettent de conclure à cette significativité.

À quoi correspond ce « p » ? Il s’agit de la probabilité de ce qu’on observe sachant l’hypothèse nulle vraie. Pour affirmer qu’un test statistique est significatif, on compare souvent ce « p » avec l’erreur de type « alpha », ou erreur de 1ère espèce, qui est la probabilité de rejeter l’hypothèse nulle alors que celle-ci est juste.

….Moui mais encore….

En fait pour bien comprendre, il faut savoir qu’en médecine on ne cherche pas vraiment à démontrer qu’une hypothèse est juste, c’est conceptuellement impossible… Donc quand on a une hypothèse, on crée un essai où on tente de démontrer que l’hypothèse qu’on veut confirmer est fausse. L’hypothèse nulle c’est donc « le truc que je veux montrer est faux ». Et si on n’arrive pas à démontrer que l’hypothèse nulle est vraie alors on considère que l’hypothèse à montrer au départ est vraie, jusqu’à preuve du contraire puisqu’on a montré que l’hypothèse nulle était fausse avec une certaine probabilité de se tromper : le petit « p », la valeur-p.

Prenons un exemple.

Nous voulons montrer que tous les corbeaux sont noirs (H1). L’hypothèse nulle (H0) sera : « il existe des corbeaux qui ne sont pas noirs ». Peu m’importe qu’ils soient vert, jaune, bleu ou blanc. S’il existe un corbeau qui n’est pas noir alors l’hypothèse nulle est vérifiée et on peut rejeter notre affirmation que tous les corbeaux sont noirs. Dans l’absolu, il faudrait recenser tous les corbeaux (et encore, on pourrait toujours dire qu’on n’a pas assez bien cherché et que peut-être il existe d’autres corbeaux). Ce n’est pas possible. Il faut donc monter un essai qui va recenser un nombre suffisant de corbeaux pour que si tous les corbeaux recensés sont noirs alors on puisse affirmer au risque de se tromper d’une probabilité « p » qu’effectivement il n’existe que des corbeaux noirs.

(Bon, si l’exemple est valable pour expliquer le « p », par contre dans le genre étude toute pourrie ça se pose là : on a ici une belle inversion de l’hypothèse nulle. Allez voir ce que c’est si vous ne connaissez pas.)

Prenons un autre exemple pour mieux comprendre avec un exemple moins moisi.

On réalise un essai clinique sur 100 patients à l’aide d’un traitement A contre un groupe contrôle de 100 patients qui reçoivent le traitement B. On obtient une guérison pour 40% des patients du groupe A et 30 % des patients du groupe B. L’essai étant bien fait, les deux groupes sont randomisés : l’appartenance de chaque patient à un groupe ou un autre est tirée au hasard. Du coup, la différence de résultat est-elle due aux fluctuations liées au tirage au sort ou s’agit-il d’un réel effet du médicament ? Si c’est dû au hasard alors l’hypothèse HO c’est que le taux de guérison pour l’ensemble des malades est identique et c’est le tirage au sort qui est responsable de la différence de proportion entre le groupe A et le groupe B, il n’y a pas de différence d’efficacité entre les traitements A et B.

Un test statistique de comparaison de deux proportions nous montre qu’ici p vaut 0,14 c’est à dire qu’il y a 14% de chance que la différence observée entre les groupes A et B soit due uniquement au hasard. C’est trop. On considérera donc que l’efficacité des deux traitements n’est pas significativement différente. On peut noter que si on prend 200 malades par groupe avec une proportion de guérison identique dans chaque groupe (A : 40% et B : 30%) alors p = 0,036 : la différence est là significative avec toutefois encore une probabilité non négligeable de se tromper. Si le budget de l’expérimentation permet de tester 1000 individus dans chaque groupe et qu’on obtient les mêmes proportions alors p = 0,000003 ! On pourrait être tenté de dire que le résultat est encore plus significatif.

Ce serait si simple si on pouvait faire comme ça.

En fait il existe deux façons d’appréhender le « p ». Une façon très formaliste dite des tests d’hypothèse de Neyman et Pearson. Et une approche plus probabiliste de Fisher, plus souple. Selon Neyman et Pearson, ce qui compte c’est la détermination a priori de « alpha » (à charge de l’expérimentateur de minimiser l’erreur de deuxième type « béta » qui consiste à rejeter l’hypothèse qu’on veut démontrer (H1) alors qu’elle est vraie).

En médecine pour d’obscures raisons, le risque « alpha » est souvent fixé à 5%. Si « p » est inférieur à « alpha » alors on rejette l’hypothèse H0 et on en déduit que H1 est vrai. S’il est supérieur à « alpha » alors on en peut pas conclure et donc on rejette H1. Dans cette approche si « p » vaut 4,9% ou 0,001% il a la même valeur puisque dans les deux cas on rejette H0. Par contre si « p » vaut 5,1% il est différent de 4,9% puisque dans le premier cas on accepte H0 et dans le second on accepte H1.

L’approche de Fisher, elle, ne considère que l’aspect probabilité d’écarter l’hypothèse nulle à tort. Dans cette approche p = 5,1% et p = 4,9% sont deux valeurs de « p » ayant à peu près la même signification alors que p = 0,001% signifie que le résultat est très significatif.

Alors on choisi quelle approche ?

Les statisticiens, les épistémologues s’écharpent depuis des années pour savoir quelle est la meilleure approche. On comprend assez facilement que, conceptuellement, les deux approches sont relativement différentes. L’approche de Neyman et Pearson est une approche a priori qui mesure un risque. Elle est très formelle mais comme le risque « alpha » est déterminé avant la réalisation de l’expérience un résultat favorable sera d’autant plus robuste. Par contre l’approche de Fisher par sa souplesse est intéressante car on interprète directement la valeur du « p » mais la contrepartie c’est que celle-ci est moins robuste puisque qu’on s’intéresse à une probabilité et non à un risque. Dans les faits en médecine, souvent les essais thérapeutiques suivent plutôt l’approche de Neyman et Pearson tandis que les études épidémiologiques utilisent l’approche de Fisher.

Comme on l’a dit, le risque « alpha » est souvent fixé à 5%. Depuis quelques années des voix s’élèvent pour fixer ce seuil à 1%. Ce changement de seuil n’est pas anodin : de très nombreuses études actuellement significatives deviendraient non valides. Ou du moins cela imposerait de reconstruire les expériences en fixant alpha à 1%. D’autres voix demandent que l’approche de Neyman et Pearson soit définitivement abandonnée au profit de celle de Fisher ; en effet les phénomènes biologiques étant essentiellement continus, les cliniciens acceptent difficilement de considérer qu’un p = 5,1% soit très différent d’un p = 4,9%. Pour simplifier encore le tout, de nombreux chercheurs ont une approche mixte de l’interprétation du « p » fixant un seuil de significativité à 5% mais attribuant une valeur de celle-ci d’autant plus grande que « p » est petit.

One more thing…

Mais… Mais alors cela veut dire que lorsqu’on a une seule étude statistiquement significative, cela ne peut pas être une preuve solide?

Et oui. Une étude est valable au risque « alpha » choisi (ou au seuil de significativité choisi) mais la probabilité d’avoir accepté l’hypothèse recherchée à tort est non nulle. C’est pour ça qu’elle doit être répliquée et reproduite. Et ne pas oublier que différence statistiquement significative ne veux pas dire différence réelle (Inférence statistique).

Et… Et ça veut dire que quand quelque chose est faux, on peut avoir pourtant des études qui le valident ?

Encore oui. Imaginons une pseudo-médecine connue comme inefficace, les grigris, pour laquelle il y a eu 1000 études testant l’efficacité. Alors, par construction, on doit trouver parmi elles environ 50 études qui démontrent que les grigris sont efficaces : 5% des études peuvent conclure à tort à l’efficacité des grigris. Et cela dans le meilleur des monde où il n’y aurait pas de biais de publication qui fait qu’une grande partie des études sans résultats significatifs ne sont publiées.

Pour une autre explication sur le petit « p » :

[crédit : La statistique expliquée à mon chat]

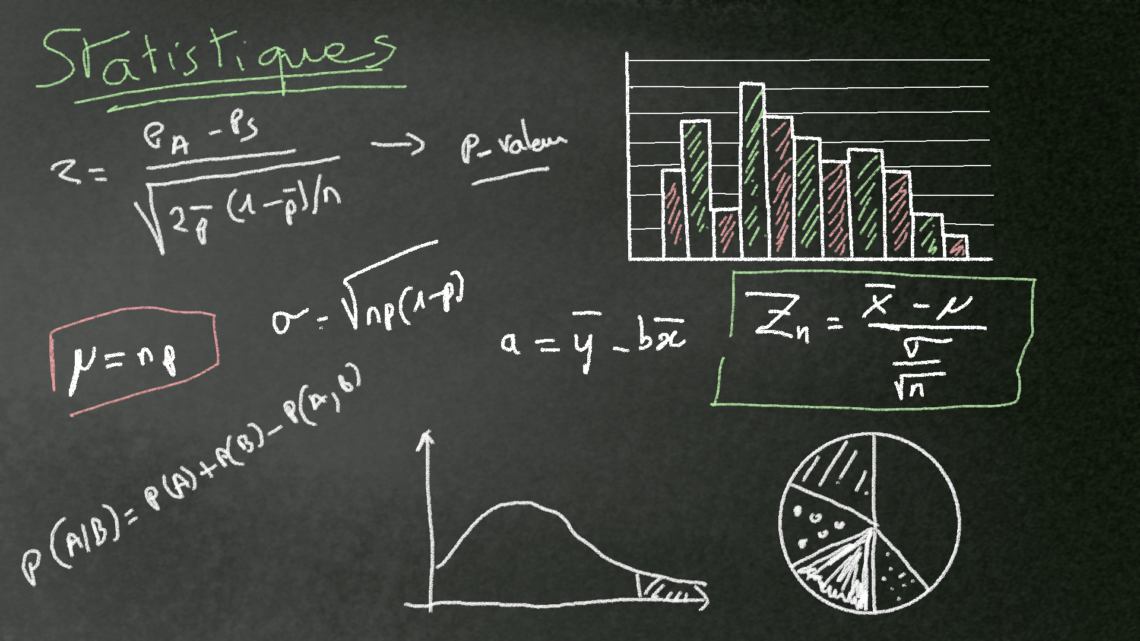

Crédit Image de titre : Jérôme Chantreau